Kernfusions-Simulation wird Vorreiter beim Übergang zu Exascale-Supercomputern

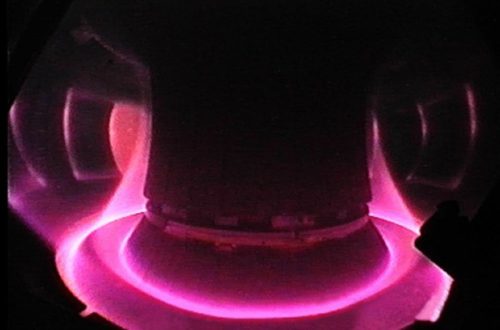

Die Plasmaphysik ist seit den 1960er Jahren einer der wichtigsten Treiber für die Weiterentwicklung von Höchstleistungsrechnern. Das liegt daran, dass Plasmen hochkomplexe Gebilde sind, die sich nicht mit einfachen physikalischen Modellen erfassen lassen. Fast das gesamte Weltall besteht aus solchen Plasmen – extrem dynamischen Gemischen aus vorwiegend geladenen Teilchen (Ionen und Elektronen). Unsere Sonne und alle anderen Sterne erzeugen daraus durch Kernfusion Energie. Um diesen Prozess auf der Erde nutzbar zu machen und um die Vorgänge im Weltall besser zu verstehen, brauchen Forschende Supercomputer.

Als Werkzeug für die Plasmaforschung starteten deshalb schon 1960 das Rechenzentrum Max Planck Computing and Data Facility (MPCDF) in Garching sowie 1974 das National Energy Research Supercomputer Center (NERSC) in den USA. Und als der US-Supercomputer Roadrunner am Los Alamos National Laboratory 2009 als erster die Petascale-Grenze durchbrach (also mehr als 1015 = eine Billiarde Rechenoperationen pro Sekunde ausführen konnte) spielte ein Plasma-Simulationscode namens VPIC dabei eine wichtige Rolle.

Auf dem Weg zu Exascale-Supercomputern

Beim jetzt bevorstehenden Sprung in Sachen High Performance Computing werden wieder Plasma-Modellierungen zu den Vorreiter-Anwendungen gehören: Es geht um den Start der ersten Exascale-Rechner in Europa. Diese können per Definition mindestens eine Trillion Rechenoperationen pro Sekunde ausführen (1 Trillion = 1018, ausgeschrieben eine 1 mit 18 Nullen). Von 2024 an wird es in Europa Supercomputer geben, die diese Schwelle überschreiten. Die Europäische Kommission stellt insgesamt mehr als sieben Millionen Euro zur Verfügung, um vier Simulationscodes für Plasmen auf das Exascale-Zeitalter vorzubereiten.

2,14 Millionen Euro von der Fördersumme gehen an den Standort Garching bei München (das Bundesministerium für Bildung und Forschung übernimmt die Hälfte der Fördersumme): Das Max-Planck-Institut für Plasmaphysik (IPP), die Max Planck Computing and Data Facility (MPCDF) und die Technische Universität München (Department of Computer Science) werden damit vom Januar 2023 an gemeinsam den GENE-Code auf ein neues Niveau heben. GENE (Gyrokinetic Electromagnetic Numerical Experiment) ist ein Open-Source-Code, der weltweit besonders für die Erforschung von Kernfusionsplasmen genutzt wird. Er kommt also dort zum Einsatz, wo Forschende daran arbeiten, nach dem Vorbild der Sonne auf der Erde Energie zu gewinnen.

Erstmals Fusionsexperimente vorhersagen

„GENE kann mit den heutigen Möglichkeiten bereits die physikalischen Ursachen für experimentelle Ergebnisse erklären, die wir zum Beispiel mit unserem Fusionsexperiment ASDEX Upgrade am IPP erzielen“, erklärt Prof. Frank Jenko, Leiter des Bereichs Tokamaktheorie am IPP in Garching. Er hat 1999 die erste Version von GENE geschrieben und den Code seitdem mit internationalen Teams stetig weiterentwickelt. „Mit einer Exascale-Version von GENE machen wir jetzt den Schritt von der Interpretation hin zur Vorhersage von Experimenten. Wir wollen ein virtuelles Fusionsplasma erschaffen, quasi den digitalen Zwilling einer realen Anlage“, erläutert Jenko das Ziel.

Ihm und seinen Kooperationspartnern geht es dabei auch um ITER, das größte Fusionsexperiment der Welt, das derzeit im südfranzösischen Cadarache gebaut wird. ITER soll zehn Mal mehr Fusionsleistung erzeugen als an Heizleistung hineingesteckt werden muss. Die Anlage ist als Vorstufe eines künftigen Fusionskraftwerks konzipiert, das dann tatsächlich Strom liefern soll. Um dieses Ziel zu erreichen, müssen die Wissenschaftler eine Vielzahl von experimentellen Parametern bei ITER so einstellen, dass sie eine möglichst günstige Kombination finden – was allein durch Ausprobieren wahrscheinlich viele Jahre dauern würde. Ein optimierter GENE-Code soll die Fusionsforschung deutlich beschleunigen. Mit ihm werden die Wissenschaftler Konfigurationen vorab durchrechnen und viele vorab ausschließen können.

Warum ist der Umstieg auf Exascale-Computer so aufwändig?

„Leider reicht es nicht, die bisherigen Programme einfach auf die neuen Computer zu transferieren“, sagt Jenko. „Leistungssprünge bei neuen Supercomputern werden heute maßgeblich durch neue Hardware-Architekturen ermöglicht. Nur wenn wir unsere Codes darauf abstimmen, können wir auch wirklich schneller rechnen.“

Jenko veranschaulicht die Aufgabe mit der Bearbeitung von Akten in der analogen Welt. „Wenn es gilt, zehn thematisch abgeschlossene Aktenordner auszuwerten, schaffen das zehn Menschen wahrscheinlich zehn Mal schneller als einer. Aber wenn plötzlich 10.000 Menschen für die zehn Ordner zur Verfügung stehen, bringt das nur etwas, wenn ich die Arbeit völlig neu organisiere und aufteile“, erklärt Jenko. Noch komplizierter werde es, wenn die 10.000 Menschen über unterschiedliche Fähigkeiten verfügen, die optimal eingesetzt werden sollen. Und wenn die Auswertung mancher Aktenordner von den Ergebnissen abhängt, die aus anderen Ordnern gewonnen werden.

Beim Umstieg zu Exascale-Computern stehen die Forschenden vor vergleichbaren Aufgaben: „Heutige Superrechner erzielen ihre Leistungssteigerung, indem sie immer mehr Rechenaufgaben parallel abwickeln und indem sie neben klassischen Prozessoren verstärkt auch Grafikprozessoren einsetzen, die aber beide unterschiedliche Stärken besitzen“, so Jenko. Um den GENE-Code auf künftige Rechnergenerationen vorzubereiten, gehören zu seinem Team deshalb auch Fachleute, die an der Konzeption künftiger Hardwaregenerationen mitwirken. Co-Design heißt diese Kollaboration in der Branche.

Von dem Projekt wird am Ende nicht nur die Fusionsforschung profitieren: „Mit dem GENE-Code sind wir Vorreiter beim Übergang zu Exascale-Rechnern“, sagt Prof. Jenko. „Was wir dabei lernen, wird auch Entwicklern anderer Programme helfen.“

Über das Förderprogramm der Europäischen Kommission

Anfang 2022 veröffentlichte die Europäische Kommission eine Ausschreibung zum Thema Centres of Excellence Preparing Applications in the Exascale Era. Dabei geht es darum, Anwendungen, die an der Spitze der technologischen Entwicklung stehen und eine breite Nutzerbasis haben, für die Verwendung auf künftigen europäischen Exascale-Supercomputern vorzubereiten. Das Ziel ist, auf diese Weise einen gewaltigen Sprung bei der Beantwortung zentraler wissenschaftlicher Fragen zu befördern. Die Finanzierung der Projekte erfolgt jeweils zur Hälfte durch die EU-Kommission und durch die Nationen, deren Institutionen teilnehmen. Als Reaktion auf diese Ausschreibung bildete sich unter der Leitung der KTH Stockholm ein interdisziplinäres Team rund um das Thema Plasmaphysik, an dem neben dem IPP auch die MPCDF, die Technische Universität München und acht weitere Partner aus Europa beteiligt sind. Das entsprechende Proposal „Pushing Flagship Plasma Simulation Codes to Tackle Exascale-Enabled Grand Challenges via Performance Optimization and Codesign (Plasma-PEPSC)” wurde nun von der Europäischen Kommission nach einer detaillierten Begutachtung für eine vierjährige Förderung (ab 1.1.2023) ausgewählt und mit einer Fördersumme von mehr als sieben Millionen Euro bedacht. Davon entfallen 2,14 Millionen Euro auf die Weiterentwicklung des GENE-Codes. Das Bundesministerium für Bildung und Forschung übernimmt 50 Prozent der Finanzierung.

Das Max-Planck-Institut für Plasmaphysik (IPP) in Garching bei München und Greifswald erforscht die physikalischen Grundlagen für ein Fusionskraftwerk, das Energie aus der Verschmelzung von leichten Atomkernen gewinnen soll. Die Arbeiten des IPP sind eingebettet in das Europäische Fusionsprogramm. Mit rund 1100 Mitarbeiterinnen und Mitarbeitern ist das IPP eines der größten Zentren für Fusionsforschung in Europa.

www.ipp.mpg.de

Max-Planck-Institut für Plasmaphysik

Boltzmannstr. 2

85748 Garching

Telefon: +49 (89) 3299-01

Telefax: +49 (89) 3299-2622

http://www.ipp.mpg.de

Pressesprecher

Telefon: +49 (89) 3299-1317

E-Mail: press@ipp.mpg.de

![]()