Warum Hörsysteme durch künstliche Intelligenz von uns lernen sollten

Seit 2018 ermöglicht künstliche Intelligenz in Form eines Machine-Learning-Verfahrens bislang noch nie dagewesene Individualisierungsprozesse im Hörsystem. Die Kombination aus der Anpassung des Hörakustikers, der Automation des Hörsystems und der flexiblen Individualisierung des Klangeindrucks, ermöglichen ein komfortables Hörerlebnis in den unterschiedlichen Hörsituationen des Alltags seiner Anwender. Denn obwohl moderne Situationsautomatiken die vorliegenden akustischen Umgebungen zuverlässig erkennen und sie dementsprechend verarbeiten, bleibt die individuelle Hörintention des Einzelnen zum Teil unberücksichtigt.

Mit einem Machine-Learning-Verfahren in Echtzeit können Hörsystem-Träger den Klang des Hörsystems in der aktuellen Situation verfeinern und auf ihre individuellen Bedürfnisse einstellen. Wie Machine Learning in Echtzeit in Widex Evoke funktioniert und welche Chancen die Weiterentwicklung künstlicher Intelligenz in Hörsystemen bietet, erfahren Sie in diesem Beitrag.

Künstliche Intelligenz oder Machine Learning?

Das Konzept der künstlichen Intelligenz ist keine Erfindung des 21. Jahrhunderts. Bereits 1950 entwickelte der Naturwissenschaftler Alan Turing den sogenannten Turing-Test, der herausfinden soll, ob die Intelligenz eines Computers bzw. einer Maschine der des Menschen entspricht (Turing, 1950). Im Zusammenhang mit künstlicher Intelligenz entstanden bereits damals der Turing-Test oder dessen Abwandlungen zur Überprüfung und Einschätzung von entwickelten Systemen.

Der Begriff künstliche Intelligenz wurde erstmals 1956 durch John McCarthy geprägt, wodurch gleichzeitig ein neues Arbeitsfeld der Computerwissenschaften entstand (Mueller & Massaron, 2018). Als künstliche Intelligenz lässt sich das Vermögen eines Computers oder einer Maschine beschreiben, die in der Lage ist, intelligentes Verhalten eines Menschen zu imitieren (Merriam-Webster, 2018). Dennoch ist der Begriff „künstliche Intelligenz“ kein Merkmal für die Aufgaben, die diese Technologie übernehmen kann. Hierzu wird definiert, welches Verfahren verwendet wird beziehungsweise worin der spezifische Anwendungsbereich liegt. Denn künstliche Intelligenz kann durch verschiedene Methoden erreicht werden, z. B. mit Elementen aus der Sensorik, neuronalen Netzwerken, Big-Data-Analysen und Machine-Learning-Anwendungen. Oft kommt es zu einer Kombination aus den unterschiedlichen Bereichen.

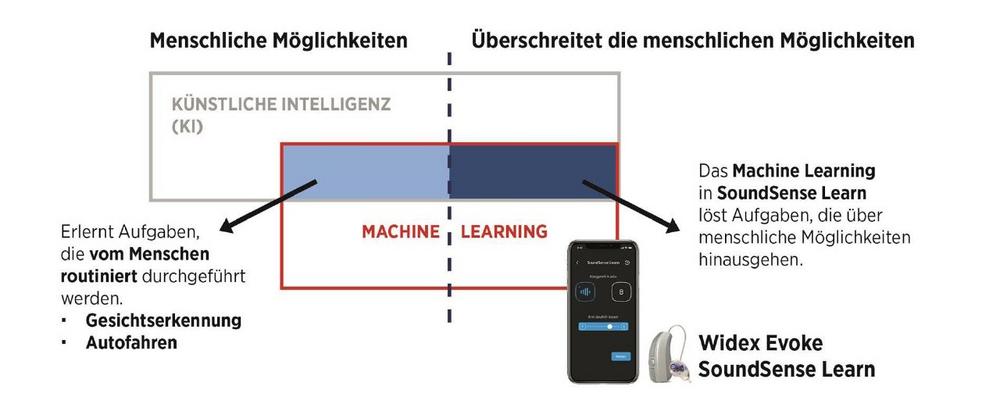

Bei Machine-Learning-Anwendungen analysiert ein System Daten und erkennt mit Hilfe selbstlernender Algorithmen in den gesammelten Daten bestimmte Muster und Gesetzmäßigkeiten. Das Ziel von Machine Learning ist es, Daten intelligent miteinander zu verknüpfen, Zusammenhänge zu erkennen, Rückschlüsse zu ziehen und valide Vorhersagen zu treffen. Dabei greift diese Art der algorithmischen Berechnung von Wahrscheinlichkeiten immer auf Daten zurück, die der Mensch selbst bereitstellt. Machine-Learning- Anwendungen arbeiten entweder im Bereich des menschenmöglichen oder sogar darüber hinaus und decken Aufgaben ab, die der Mensch nur schwer lösen kann (siehe Abbildung 1).

Mit dem Einsatz von Machine Learning schafft Widex eine Symbiose aus der Anpassung des Hörakustikers und der Individualisierungsmöglichkeit über künstliche Intelligenz – gesteuert über die individuellen Rückmeldungen des Hörsystemträgers.

Mit künstlicher Intelligenz zum gewünschten Klang

Die Erforschung akustischer Szenarien ist ein wesentlicher Gegenstand der Forschung und Entwicklung von Hörsystemen. Dadurch werden Erkenntnisse erlangt, wie reale Hörsituationen für Hörsystem-Träger definiert werden können und wie relevant sie für deren Alltag sind (Smeds et al., 2015; Wolters et al., 2016). Diese Erkenntnisse werden beispielsweise herangezogen, um die digitale Signalverarbeitung in Hörsystemen zu optimieren. Moderne Hörsysteme – wie das 2018 vorgestellte Widex Evoke – verfügen über adaptive Situationserkennungen, die es dem Hörsystem ermöglichen, seine Signalverarbeitungs-Strategie automatisch auf die jeweilige erkannte akustische Szene anzupassen. Die Situationsautomatik von Widex Evoke verfügt dafür über bis zu elf Hörwelt-Kategorien, welche die wesentlichen Hörsituationen des Alltags widerspiegeln. Die Funktionsweise der Situationsautomatik basiert auf dem Prinzip, den Hörverlust des Hörgeräteträgers in jeder Hörsituation bestmöglich auszugleichen und ein natürliches, müheloses Hören durch eine originalgetreue, klare Klangwiedergabe zu gewährleisten. Die Grundeinstellung der Automatik in den jeweiligen Hörwelt- Kategorien beruht auf dem Wissen, welche Feature-Konfiguration in der Regel hierfür am besten geeignet ist (Townend et al., 2018). Die Einstellungen der Automatik entsprechen zum Großteil den Erwartungen des Hörgeräte-Trägers. Die automatische Steuerung von Hörsystemen stellt die Hörsystem-Entwicklung jedoch auch vor Herausforderungen: Die individuelle Hörintention des Hörsystem-Trägers in seiner aktuellen, realen Hörumgebung bleibt unberücksichtigt, beziehungsweise basiert auf allgemeingültigen Annahmen.

Die Hörintention eines Hörsystemträgers kann aufgrund individueller Einflussfaktoren variieren, z. B. durch die persönliche Stimmungslage oder einen unterschiedlichen Kontext der jeweiligen Hörsituation. Ein Beispiel: Sitzt ein Hörsystem-Träger in einem Cafe, um ein Buch zu lesen, beabsichtigt er gegebenenfalls, eine andere akustische Wahrnehmung seines Umfelds als beim Treffen mit seinen Freunden in der identischen akustischen Hörumgebung. Künstliche Intelligenz im Hörsystem erlaubt es Hörsystemträgern, schnell und einfach das Hörsystem auf den situativ bevorzugten Klang einzustellen.

Das Hörsystem erhält keine Information darüber, ob der Hörsystemträger ein Buch lesen oder sich in derselben akustischen Situation unterhalten möchte. Um den Klang – je nach Hörintention – zu optimieren, benötigt das Hörsystem über die akustische Hörsituation hinausgehende Informationen des Anwenders. Dies ermöglicht das Hörsystem Evoke durch künstliche Intelligenz mit der Machine-Learning-Funktion SoundSense Learn.

Das KI-System – SoundSense Learn

Die Funktion SoundSense Learn basiert auf intelligenten, patentierten Machine-Learning-Algorithmen und erfordert eine hohe Rechenleistung für die intelligente Verarbeitung großer und komplexer Datenmengen. Evoke nutzt hierfür die externe hohe Rechenkapazität eines Smartphones in Form einer intuitiven App-Funktion und verknüpft diese via 2,4-GHz-Low-Energy-Bluetooth mit der Chipplattform im Hörsystem. (Abbildung 2).

Resultat ist eine innovative Klangoptimierung, die auf der tatsächlichen Hörintention des Hörsystem-Träger in seiner momentanen, realen Hörsituation basiert.

Um den Machine Learning Algorithmus in zukünftigen App-Versionen weiter zu optimieren und ein noch besseres Hörerlebnis für alle Evoke-Träger zu realisieren, werden die Resultate der KI-Funktion zur weiteren Analyse anonymisiert an die Widex-Cloud gesendet. Bei den übertragenen Daten handelt es sich nicht um personenbezogene Informationen, sondern lediglich um Lernergebnisse aus dem Machine-Learning- Verfahren.

Die Verwendung von SoundSense Learn

Die Funktion SoundSense Learn wird vom Hörgeräte-Träger über die Widex Evoke-App bedient. Über einen A/B-Vergleich werden Daten über die Klangvorlieben des Nutzers gewonnen. Dazu werden ihm in Echtzeit zwei unterschiedliche Klangeindrücke (A/B) für seine aktuelle Hörsituation vorgeschlagen. Der Anwender wählt die Klangvariante aus, die seiner Hörintention mehr entspricht, und wird so schrittweise zu der für ihn idealen Klangeinstellung geführt. Der Unterschied der beiden Höreindrücke (A/B) ergibt sich durch eine Veränderung der Verstärkungswerte eines 3-Band-Equalizers (Tiefen/Mitten/Höhen), der der künstlichen Intelligenz zugrunde liegt. SoundSense Learn lernt, welchen Klangeindruck der Anwender erwartet, und bietet darauf basierend neue Hörbeispiele an (Nielsen et al., 2013). Die Antworten tragen dazu bei, den gewünschten Klang über den Equalizer sehr schnell zu identifizieren (Nielsen, 2014; Townend et al., 2018). Beeindruckend ist die Geschwindigkeit, in der das System zum Ziel findet: Der im Hintergrund wirkende 3-Band-Equalizer erlaubt jeweils 13 Einstellpositionen pro Band. Die daraus resultierenden 2.197 Einstellmöglichkeiten würden theoretisch zu über 2,4 Millionen Direktvergleichen führen. Durch das intelligente Erforschen der persönlichen Hörintention des Hörsystem-Trägers gelangt der Machine-Learning-Algorithmus bereits in maximal 15 A/B-Vergleichen zum Ziel. Die Optimierung kann in der Evoke-App als Lieblingsprogramm gespeichert oder nur für diesen Moment verwendet werden. In Kombination mit der zugrunde liegenden Einstellung des Hörakustikers sowie der adaptiven Situationsautomatik und Signalverarbeitung in Widex Evoke führt die Symbiose aus Mensch und Maschine zu einer gesteigerten Nutzerzufriedenheit. Die Einstellungen des Hörakustikers im Hörsystem werden durch SoundSense Learn nicht verändert und auch die Einstellungen der Signalverarbeitungs-Parameter bleiben unberührt.

SoundSense Learn – erste Ergebnisse

Die Relevanz von SoundSense Learn wurde durch Widex bereits in zwei Studien untersucht. Der Fokus lag vor allem auf den unterschiedlichen Anwendungsbereichen (Studie 1) und auf der Nutzerzufriedenheit (Studie 2). Durch eine erste Analyse der anonymen Cloud-Daten, kurze Zeit nach der Markteinführung von Evoke, konnten die Entwickler bei Widex erkennen, wie und in welchen Hörsituationen SoundSense Learn hauptsächlich genutzt wird (Studie 1). Die Datenauswertung setzt den Fokus auf regelmäßig genutzte Programme, die über künstliche Intelligenz erstellt wurden. Eine regelmäßige Nutzung bedeutet, dass ein gespeichertes Programm in der Woche nach seiner Erstellung mindestens einmal verwendet wurde. Zusätzlich muss diesem Programm über die App ein Verwendungsbereich zugeordnet sein, zum Beispiel „Restaurant“ oder „Arbeitsplatz“.

In diese Statistik fließen keine Daten von SoundSense Learn ein, die nicht gespeichert oder nur einmal genutzt wurden. Eine einmalige Nutzung deutet darauf hin, dass es sich hierbei um eine klangliche Optimierung handelt, die anhand der Hörsituation oder der Intention einmalig war und daher nicht für einen regelmäßigen Gebrauch erstellt wurde. Dies lässt auch darauf schließen, dass die automatische Einstellung der Signalverarbeitungs- Parameter in Evoke einen Großteil der Hörsituationen zu einer hohen Zufriedenheit der Hörsystem-Träger abdeckt. Es zeigt jedoch auch, dass SoundSense Learn als ein nützliches Werkzeug in speziellen Hörsituationen gesehen wird und deswegen nicht immer als Zusatzprogramm für spätere Nutzungen hinterlegt werden muss (Balling et al., 2019; Martin & Townend, 2018). Die in der Widex-Auswertung erhobenen Daten lassen eine gute Schlussfolgerung auf den Gebrauch in unterschiedlichen Hörsituationen zu. Betrachtet man die nach Evoke- Einführung erhaltenen Daten in einer ersten Analyse, kann man den rund 1.800 regelmäßig verwendeten Programmen einen Anwendungsbereich zuordnen (Abbildung 3). Hervorzuheben sind die Anwendungsbereiche „TV“ (21 Prozent) und „Arbeitsplatz“ (8 Prozent). Die Hörsituation am Arbeitsplatz wird in Umfragen (Abrams & Kihm, MarkeTrak, 2015) oft mit „zufriedenstellend“ (83 Prozent) bewertet. Gleichzeitig bedeutet dies jedoch auch, dass ungefähr jeder fünfte Hörsystem-Träger mit seiner Hörsituation am Arbeitsplatz unzufrieden ist (Martin & Townend, 2018).

Betrachtet man die individuell erstellten Arbeitsplatz-Programme isoliert (Abbildung 4), lässt sich erkennen, wie divers die einzelnen Parameter des 3-Band-Equalizers (Tiefen/Mitten/Höhen) über SoundSense Learn eingestellt sind. Die individuellen Einstellungen lassen sich somit nur schwer über eine einzelne für jeden Arbeitsplatz vorgefertigte Arbeitsplatz-Voreinstellung, wie sie in einer Situationsautomatik verwendet werden könnte, abdecken. Eine einfache Individualisierungsmöglichkeit durch den Hörsystem-Träger mit SoundSense Learn ist daher von Vorteil.

In einer zweiten umfangreichen Studie (Balling et al., 2019) mit 118 Studienteilnehmern (w = 38, m = 79) zwischen 18 und 89 Jahren (Durchschnittsalter = 63 Jahre, Standardabweichung = 15 Jahre) aus insgesamt neun Ländern (Kanada, China, Tschechien, Ungarn, Italien, Japan, Portugal, Großbritannien und den USA) wurden den Studienteilnehmern jeweils Evoke 440 Fusion2-Hörsysteme angepasst. Die Hörminderung aller Teilnehmer befand sich beidseitig im Anpassbereich des Widex M-Hörers. Die Studie ermittelte unter anderem die Zufriedenheit der Nutzer mit SoundSense Learn. 72 Prozent (38 aus 53) der Studienteilnehmer gaben an, dass sie durch SoundSense Learn eine Verbesserung in ihrer Hörsituation erfahren haben. 80 Prozent (42 aus 53) der Befragten würden SoundSense Learn anderen Hörsystem-Trägern empfehlen.

Die Ergebnisse zeigen, dass nicht jeder Studienteilnehmer SoundSense Learn in der Erprobungszeit genutzt hat. Dies war zu erwarten, da die automatische Systemsteuerung der digitalen Signalverarbeitung in Evoke in den meisten Hörsituationen eine adaptive Anpassung an die Hörumgebung in den Bereichen Hörbarkeit, Sprachverständlichkeit und Klangqualität erzielt. Sind die Hörsystem-Träger in diesen Situationen bereits zufrieden, ist eine weitere Einstellung über SoundSense Learn nicht notwendig.

Die zweite Generation SoundSense Learn

Dank weltweit Tausender SoundSense Learn-Anwendungen von Evoke-Nutzern und den gespeicherten Lieblingsprogrammen ist es Widex gelungen, die Funktion SoundSense Learn maßgeblich weiterzuentwickeln.

Der Machine-Learning-Algorithmus in der zweiten Generation SoundSense Learn lässt Anwender 25 Prozent schneller zum gewünschten Klang finden. Es werden nur noch rund 15 A/B-Vergleiche (zuvor 20) für ein perfekt individualisiertes Klangerlebnis benötigt. SoundSense Learn kann die Konvergenz des Lernfortschritts selbst errechnen und weiß, wann das Ziel erreicht wurde. Die neu entwickelte Benutzeroberfläche mit Fortschrittsanzeige gibt dem Nutzer in Echtzeit eine intelligente Rückmeldung, wie schnell er sein personalisiertes Klangerlebnis erzielt. Diese Informationen, das schnellere Lernverfahren sowie die Möglichkeit, schon zu Beginn auszuwählen, für welche Hörsituation man eine klangliche Optimierung erlangen möchte, schaffen eine neue Stufe der Anwenderfreundlichkeit von SoundSense Learn.

Zusammenfassung

Unser Hörempfinden ist so individuell wie die Hörsituationen des Alltags. Hinzu kommt eine unterschiedliche Klangwahrnehmung, bedingt durch individuelle Hörintentionen, die wir in diesen Hörsituationen anstreben. Dies verlangt nach einem Hörsystem, das sich auf jedes akustische Szenario anpassen kann und das gleichzeitig individuelle Hörwünsche des Hörgeräte-Trägers in bestimmten Situationen ad hoc berücksichtigt. Widex erfüllt diesen Anspruch mit dem Hörsystem Evoke. Dieses Hörsystem kombiniert eine fortschrittliche Situationsautomatik mit maximaler Individualisierung. Die Machine-Learning-Funktion SoundSense Learn erlaubt dem Hörsystem-Träger erstmals, das Klangbild seines Hörsystems in Echtzeit auf seine individuelle Hörintention in einer bestimmten Hörsituation einzustellen.

Die vorgestellten Studienergebnisse verdeutlichen die Vielseitigkeit und die hohe Bedeutung von SoundSense Learn im Alltag des Hörsystem-Trägers. Die Nutzer erstellen Klangoptimierungen für die unterschiedlichen Hörsituationen und speichern sie als Zusatzprogramm (Abbildung 3 und 4) oder optimieren den Klang nur für den Moment. Die erhobenen Daten zeigen, dass die Einstellungen über SoundSense Learn so vielschichtig sind, dass sie nicht über eine allgemeingültige Veränderung der Einstellung oder Anpassformel abgedeckt werden können (Abbildung 4). Dank der Kombination aus Automation und Personalisierung steigert Widex Evoke die Zufriedenheit der Hörsystem-Träger. Gleichzeitig lernt Widex aus der Analyse anonymer Benutzerdaten, sodass Evoke-Nutzer auf der ganzen Welt von einem noch präziseren und besseren Klangerlebnis profitieren können.

Der Artikel erschien ursprünglich in der Ausgabe 05/2019 der „Hörakustik“.

Autor:

Simon Müller ist seit 2017 audiologisch-wissenschaftlicher Leiter bei der Widex Hörgeräte GmbH in Stuttgart. Nach einem Bachelor in Augenoptik und Hörakustik an der Hochschule Aalen im Jahr 2011 erlangte er 2012 den Master of Science in Audiology an der University of Manchester. Praktische Erfahrung sammelte er als Betriebsleiter eines Hörakustikfachgeschäfts und als audiologischer Leiter an der Rheinisch-Westfälischen Technischen Hochschule (RWTH) Aachen.

Quellen:

Abrams, H. B. & Kihm, J. (2015) An introduction to MarkeTrak IX: A new baseline for the hearing aid market.

Hearing Review. 2015; 22(6): 16–21.

Balling, L. W., Townend, O. & Switalski, W. (2019) Real-life Hearing Aid benefit with Widex EVOKE. Hearing Review. 2019; 26(3): 30–36.

Daugherty, P. R. (2018) Human + Machine Reimagining Work in the Age of AI. Boston, Massachusetts: Harvard Business review Press.

Martin, J. W. & Townend, O. (2018) SoundSense Learn: Machine Learning Revisited and Initial Data Findings.

Hearinghealthmatters.org, November 6, 2018; https://hearinghealthmatters.org/… learning-widex-evoke-hearing-aid/.

Merriam-Webster (2018) Website aufgerufen via: https://www.merriam-webster.com/… intelligence.

Mueller, J. P. & Massaron, L. (2018) Machine Learning for dummies. New Jersey: John Wiley & Sons Inc.

Nielsen, J. B., Nielsen, J., Jensen, B. S., Larsen, J. (2013) Hearing aid personalization. Paper presented at: 27th Conference on Neural Information Processing Systems (NIPS); December 5–10, 2013; Lake Tahoe, Nev. http://

eprints.gla.ac.uk/119556/1/119556.pdf.

Nielsen, J. B. (2014) System for Personalization of Hearing Instruments – A Machine Learning Approach. Danish Technical University (DTU).

Smeds, K., Wolters, F., Rung, M. (2015) Estimation of signal-to-noise ratios in realistic sound scenarios. J Am Acad Audiol; 26(2): 183–196.

Turing, A. M. (1950) Computing Machinery and Intelligence. Mind, 49(236): 433–460.

Townend, O., Nielsen, J. B. & Balslev, D. (2018) SoundSense Learn – Listening Intention and Machine Learning.

Hearing Review. 2018; 25(6): 28–31.

Wolters, F., Smeds, K., Schmidt, E., Christensen, E. K., Norup, C. (2016) Common Sound Scenarios: A Context- Driven Categorization of Everyday Sound Environments for Application in Hearing-Device Research. J Am Acad Audiol; 27: 527–540.

Widex Hörgeräte GmbH

Epplestraße 225

70567 Stuttgart

Telefon: +49 (711) 7895-0

Telefax: +49 (711) 7895-200

http://www.widex-hoergeraete.de

Content Managerin

Telefon: 0711/7895-152

E-Mail: peggy.reiss@widexsound.com

![]()